蜘蛛强引代码,dnf所有代码,要最全的?

以下地图代码

[ post]地图ID

洛兰

地图ID: 1 = 洛兰

地图ID: 2 = 洛兰深处

洛兰之森

地图ID: 3 = 幽暗密林

地图ID: 4 = 幽暗密林深处

地图ID: 5 = 雷鸣废墟

地图ID: 6 = 猛毒雷鸣废墟

地图ID: 7 = 格拉卡

地图ID: 8 = 烈焰格拉卡

天空之城

地图ID: 11 = 亚蒙下层

地图ID: 12 = 亚蒙上层

地图ID: 13 = 世帕罗塔下层

地图ID: 14 = 世帕罗塔上层

地图ID: 15 = 天空之海浅海

地图ID: 16 = 天空之海深海

天帷巨兽

地图ID: 21 = 神殿外围

地图ID: 22 = 树精丛林

地图ID: 23 = 炼狱

地图ID: 24 = 极昼

地图ID: 25 = 第一脊椎

地图ID: 26 = 第二脊椎

暗黑城

地图ID: 31 = 浅栖之地

地图ID: 32 = 蜘蛛洞穴

地图ID: 34 = 熔岩穴

地图ID: 35 = 暗精灵墓地

地图ID: 36 = 暗黑城入口

万年雪山

地图ID: 40 = 山脊

地图ID: 41 = 冰心少年

地图ID: 42 = 利库天井 (39-42) 最低进入等级36

地图ID: 43 = 白色废墟 (45-48) 最低进入等级42

地图ID: 44 = 冰雪宫殿 (48-51) 最低进入等级45

地图ID: 45 = 斯卡萨之巢 (53-56) 最低进入等级50

洛斯玛尔

地图ID: 50 = 堕落的盗贼

地图ID: 51 = 迷乱之村哈穆

其他隐藏图蜘蛛强引代码:悬空 17 遗迹 33 机械牛1500 悲鸣 1501 死亡の塔 11000

=============================================================================

代码大全(方便查找)

20001 波动剑

20002-20007 自身尖兵柱 打低级怪效果好

20008 修罗半月

20009 怒气爆发(无伤害) 偏上

20010 怒气爆发的伤害

20011 红阵

20012 冰阵

20013 绿阵

20014 墓碑

20015 自己身上墓碑

20016 银光落刃

20017 抓头

20018 阿修罗震 无影像

20019 小邪光斩

20020 前突刺第二刀

20021 虚电球 修罗大电

20022 裂波斩

20023

python爬虫怎么做?

大到各类搜索引擎,小到日常数据采集,都离不开网络爬虫。爬虫的基本原理很简单,遍历网络中网页,抓取感兴趣的数据内容。这篇文章会从零开始介绍如何编写一个网络爬虫抓取数据,然后会一步步逐渐完善爬虫的抓取功能。

工具安装

我们需要安装python,python的requests和BeautifulSoup库。我们用Requests库用抓取网页的内容,使用BeautifulSoup库来从网页中提取数据。

安装python

运行pip install requests

运行pip install BeautifulSoup

抓取网页

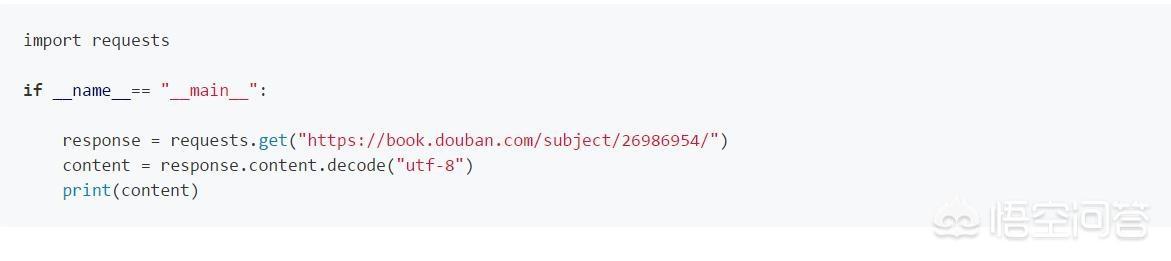

完成必要工具安装后,我们正式开始编写我们的爬虫。我们的第一个任务是要抓取所有豆瓣上的图书信息。我们以://book.douban.com/subject/26986954/为例,首先看看开如何抓取网页的内容。

使用python的requests提供的get()方法我们可以非常简单的获取的指定网页的内容, 代码如下:

提取内容

抓取到网页的内容后,我们要做的就是提取出我们想要的内容。在我们的第一个例子中,我们只需要提取书名。首先我们导入BeautifulSoup库,使用BeautifulSoup我们可以非常简单的提取网页的特定内容。

连续抓取网页

到目前为止,我们已经可以抓取单个网页的内容了,现在让我们看看如何抓取整个网站的内容。我们知道网页之间是通过超链接互相连接在一起的,通过链接我们可以访问整个网络。所以我们可以从每个页面提取出包含指向其它网页的链接,然后重复的对新链接进行抓取。

通过以上几步我们就可以写出一个最原始的爬虫。在理解了爬虫原理的基础上,我们可以进一步对爬虫进行完善。

写过一个系列关于爬虫的文章::///i6567289381185389064/。感兴趣的可以前往查看。

Python基本环境的搭建,爬虫的基本原理以及爬虫的原型

Python爬虫入门(第1部分)

如何使用BeautifulSoup对网页内容进行提取

Python爬虫入门(第2部分)

爬虫运行时数据的存储数据,以SQLite和MySQL作为示例

Python爬虫入门(第3部分)

使用selenium webdriver对动态网页进行抓取

Python爬虫入门(第4部分)

讨论了如何处理网站的反爬虫策略

Python爬虫入门(第5部分)

对Python的Scrapy爬虫框架做了介绍,并简单的演示了如何在Scrapy下进行开发

Python爬虫入门(第6部分)