百度蜘蛛强引代码,黑客攻击用的最短代码是什么?

我来给你们一个靠谱回答百度蜘蛛强引代码。

有人讲菜刀一句话,有人讲跨站最短字符,有人讲溢出字节数,有人讲系统命令,这些都是有点弱的。

第一,我们讲的是攻击过程中用到的代码,不是你攻击过程中准备的软件代码。

第二,我们讲的是现在应当能成功攻击的。不是你已经装好后门你去连接了,像菜刀服务端、跨站代码等。

接近这个答案,有两种:

1、真正的dir溢出

医科圣手tombkeeper,在知乎上举过例子。

在简体中文版 Windows 2000 SP4 的命令提示符下执行这条 dir 命令会导致系统锁屏:

dir aux.AAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAA蛺矣

这是他早年做安全编程培训讲缓冲区溢出的时候,制作的一个演示例子。

虽然“dir 溢出”是个流传已久的笑话,但其实 dir 真的可以溢出,直到 Windows XP 都还可以。汉字“蛺矣”的 Unicode 内码是 FA 86 E3 77。而在 Windows 2000 SP4 上,0x77E386FA 是 USER32!LockWorkStation 的地址。原理很简单,效果还是很酷的。

2、还有比上边代码更简单的,黑客攻击还能用到的攻击代码吗?

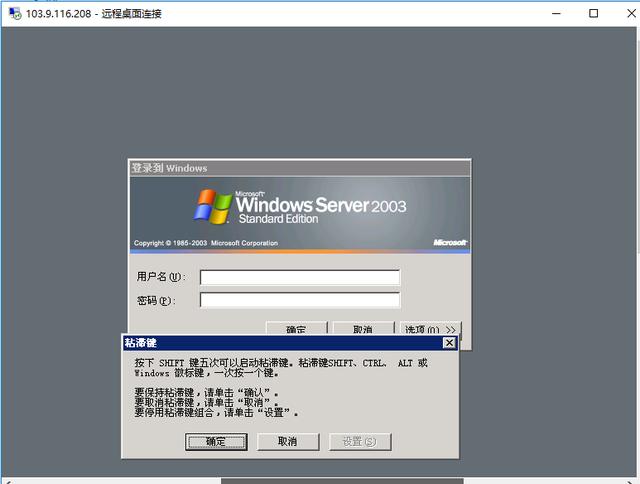

有的,就是5下shift键。现在很多黑客黑了服务器之后,会装一个shift后门。许多网络渗透者检测一台服务器开3389端口后,往往会在登陆界面上按5下shift键,看看有没有别人装的后门,黏贴键有没有被别的黑客改动过,从而来捡一个大便宜。这绝对算是攻击的一种方式,也是最短的代码了,只有5下shift键。同理还有放大镜后门。

python爬虫怎么做?

大到各类搜索引擎,小到日常数据采集,都离不开网络爬虫。爬虫的基本原理很简单,遍历网络中网页,抓取感兴趣的数据内容。这篇文章会从零开始介绍如何编写一个网络爬虫抓取数据,然后会一步步逐渐完善爬虫的抓取功能。

工具安装

我们需要安装python,python的requests和BeautifulSoup库。我们用Requests库用抓取网页的内容,使用BeautifulSoup库来从网页中提取数据。

安装python

运行pip install requests

运行pip install BeautifulSoup

抓取网页

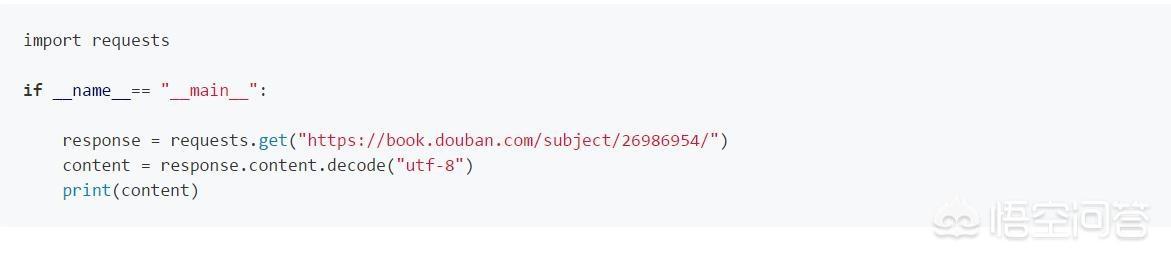

完成必要工具安装后,我们正式开始编写我们的爬虫。我们的第一个任务是要抓取所有豆瓣上的图书信息。我们以://book.douban.com/subject/26986954/为例,首先看看开如何抓取网页的内容。

使用python的requests提供的get()方法我们可以非常简单的获取的指定网页的内容, 代码如下:

提取内容

抓取到网页的内容后,我们要做的就是提取出我们想要的内容。在我们的第一个例子中,我们只需要提取书名。首先我们导入BeautifulSoup库,使用BeautifulSoup我们可以非常简单的提取网页的特定内容。

连续抓取网页

到目前为止,我们已经可以抓取单个网页的内容了,现在让我们看看如何抓取整个网站的内容。我们知道网页之间是通过超链接互相连接在一起的,通过链接我们可以访问整个网络。所以我们可以从每个页面提取出包含指向其它网页的链接,然后重复的对新链接进行抓取。

通过以上几步我们就可以写出一个最原始的爬虫。在理解了爬虫原理的基础上,我们可以进一步对爬虫进行完善。

写过一个系列关于爬虫的文章::///i6567289381185389064/。感兴趣的可以前往查看。

Python基本环境的搭建,爬虫的基本原理以及爬虫的原型

Python爬虫入门(第1部分)

如何使用BeautifulSoup对网页内容进行提取

Python爬虫入门(第2部分)

爬虫运行时数据的存储数据,以SQLite和MySQL作为示例

Python爬虫入门(第3部分)

使用selenium webdriver对动态网页进行抓取

Python爬虫入门(第4部分)

讨论了如何处理网站的反爬虫策略

Python爬虫入门(第5部分)

对Python的Scrapy爬虫框架做了介绍,并简单的演示了如何在Scrapy下进行开发

Python爬虫入门(第6部分)