浅谈搜索引擎的工作原理

前面2期介绍seo的时候就讲到了关于SEO的基本定义,这里再次简单回顾下吧!

SEO(搜索引擎优化)通常定义为:在了解搜索引擎的工作原理基础上,对网站进行内外调整优化,提高网站关键词排名,获得更多流量,达成网站的营销目的。通过这一定义,我们可以看到,做SEO首先需要知道我们搜索引擎的工作原理是怎样的,只有搞清楚它的原理,我们才可以本着这一原理进行做后期优化工作。这就是今天这一期重点和大家分享的话题:搜索引擎的工作原理!

由于搜索引擎这一块的专业知识涉及很广,可以单独作为一门学科来系统化学习的,所以建议新手刚开始学SEO的时候可以先多学习下搜索引擎这一块知识哦,也可以自己买本搜索引擎原理的书籍看看也行,只有理解了搜索引擎的工作原理后,我们对后期优化工作才有了明确的方向!

搜索引擎的工作原理

首先搜索引擎的工作原理大体上分为三个阶段:

- 爬行与抓取:搜索引擎蜘蛛(Spider)通过跟踪链接发现和访问页面,然后读取html代码,存入数据库中;

- 预处理:搜索引擎蜘蛛抓取来的页面数据进行文字提取,中文分词,索引(正向索引),倒排索引等,以备后面排名和展现;

- 排名:通过一定的搜索相关性计算,按照一定格式生成搜索结果页面。

搜索引擎的工作原理

针对这三个阶段详细说下搜索引擎的工作原理:

爬行与抓取

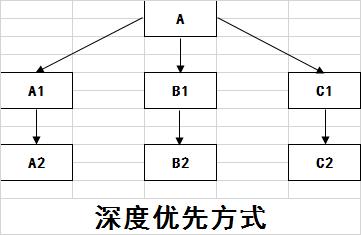

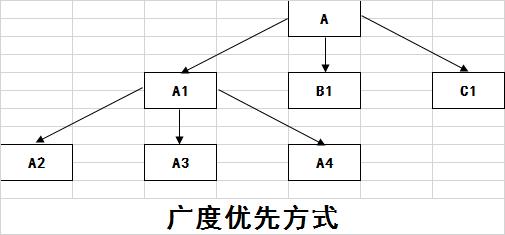

1、跟踪链接:一般是深度优先和广度优先两种跟踪方式,如图所示:

深度优先跟踪链接

广度优先跟踪链接

理论上,无论是哪种跟踪方式,只要给蜘蛛足够多时间,都能爬完整个互联网上的链接,但实际上,蜘蛛的宽带资源和时间都是非常有限的,不可能爬完所有的链接,最多只能爬行和收录一小部分,所以我们做SEO工作就需要主动吸引蜘蛛来爬行和收录我们的页面。

2、吸引蜘蛛:哪些页面可以吸引到蜘蛛呢?符合以下几点就足以。

- 第一,网站和页面权重。权重越高,蜘蛛就越喜欢,尤其是老网站,质量高的网站;

- 第二,页面更新频率。蜘蛛喜欢新鲜事物,所以网站这一块也需要经常多跟新;

- 第三,导入链接。无论是外链还是内链,只要多给蜘蛛爬行页面的路径,页面收录率和排名会更高;

- 第四,与首页点击距离。一般网站首页权重最高,所以页面里首页的点击距离越近,爬行和收录机会更高;

- 第五,URL结构。首先符合静态化最好,其次URL越短,层次越少,蜘蛛爬行的机会就更大些,页面收录机会也就更大。

预处理

这里所说的预处理包括:提取文字,中文分词,去停止词,消除噪声,去重,正向索引,倒排索引,链接关系计算,特殊文件处理以及质量判断等等,由于内容过多,这里不多做详细说明,主要讲下正向索引和倒排索引这两块核心内容,有些书籍把预处理这一阶段定义为索引,其实也是说明了正向索引和倒排索引的重点,首先看下面示意图:

正向索引结构

倒排索引结构

上图中文件就是指页面了,关键词就是与用户所搜索的词相匹配的关键词,这里的关键词是搜索引擎内部存储的关键词,也是基于过去用户所搜索过的词,进行一次收集和整理所得出来的。通过对比两种索引结构就可以看出,倒排索引更能符合搜索引擎的工作要求,当用户搜索某一关键词时候,搜索引擎系统内部便能一次性直接导出与关键词相匹配的页面,然后再通过链接相关性计算,特殊文件处理,页面质量判断得出哪些页面可以用作搜索结果页面中,最后以排名的方式显示出来。

排名

进行预处理过后,尤其是倒排索引处理之后,然后对用户搜索词处理以及相应的文件匹配,得出初始文件的子集,这里的初始文件子集并不能直接用于排名,还要进行相关性计算,排名过滤和调整,最终显示出页面的排名结果。这里的相关性计算,主要是根据关键词常用程度、词频和密度、关键词位置及形式、关键词距离、链接分析及页面权重等来得出页面的内容是否和用户搜索的词高度相关。

好了,关于搜索引擎的工作原理大致上就说这么多了,其实还有很多详细地方没有具体说到,由于涉及过广,大家可以多了解下搜索引擎这一块的内容,可以借助相关书籍来系统学习这一块的内容哦!本期的SEO分享就到这里了,大家有任何问题和想法都可以在评论下方留言咨询哦!